运维必备:掌握这3个存储技术

高级文件系统管理:LVM、RAID、NFS深度解析

前言

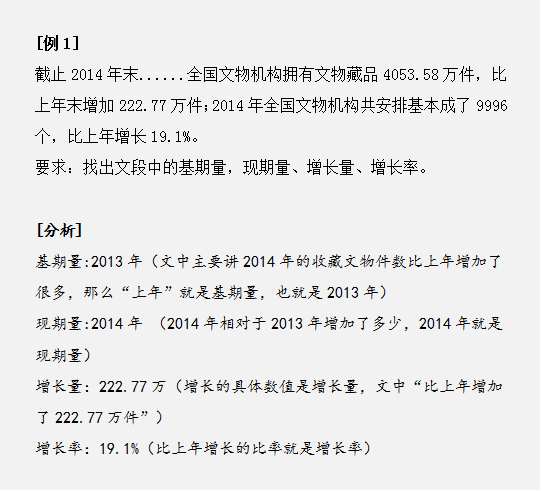

在现代企业级Linux环境中,文件系统管理是运维工程师必须掌握的核心技能。随着数据量的爆炸式增长和业务连续性要求的提高,传统的单磁盘文件系统已经无法满足企业需求。本文将深入探讨三种关键的高级文件系统管理技术:LVM(逻辑卷管理)、RAID(独立磁盘冗余阵列)和NFS(网络文件系统),为运维工程师提供全面的技术指导。

一、LVM(逻辑卷管理)

1.1 LVM概述

LVM是Linux环境下的逻辑卷管理器,它在物理磁盘和文件系统之间添加了一个逻辑层,提供了灵活的磁盘管理方案。LVM的核心优势在于支持动态扩容、快照备份和磁盘迁移等高级功能。

1.2 LVM架构组件

LVM架构包含三个主要层次:

物理卷(Physical Volume, PV):将物理磁盘或分区初始化为LVM可识别的格式。每个PV包含一个卷组描述符区域(VGDA)和多个物理扩展(PE)。

卷组(Volume Group, VG):由一个或多个PV组成的存储池。VG是LVM管理的基本单位,类似于传统的磁盘分区表。

逻辑卷(Logical Volume, LV):从VG中分配空间创建的逻辑分区。LV可以跨越多个PV,为上层文件系统提供存储空间。

1.3 LVM实战配置

创建物理卷

# 创建PV pvcreate /dev/sdb1 /dev/sdc1 # 查看PV状态 pvdisplay pvs

创建卷组

# 创建VG vgcreate vg_data /dev/sdb1 /dev/sdc1 # 查看VG状态 vgdisplay vg_data vgs

创建逻辑卷

# 创建LV(指定大小) lvcreate -L 10G -n lv_web vg_data # 创建LV(指定PE数量) lvcreate -l 100%FREE -n lv_database vg_data # 查看LV状态 lvdisplay lvs

1.4 LVM高级管理

动态扩容

# 扩展LV lvextend -L +5G /dev/vg_data/lv_web # 或者扩展到指定大小 lvextend -L 15G /dev/vg_data/lv_web # 同时扩展文件系统 lvextend -L +5G -r /dev/vg_data/lv_web

创建快照

# 创建快照 lvcreate -L 2G -s -n lv_web_snapshot /dev/vg_data/lv_web # 挂载快照进行备份 mount /dev/vg_data/lv_web_snapshot /mnt/backup

PV迁移

# 迁移PV数据 pvmove /dev/sdb1 /dev/sdd1 # 从VG中移除PV vgreduce vg_data /dev/sdb1

二、RAID(独立磁盘冗余阵列)

2.1 RAID技术概述

RAID通过将多个物理磁盘组合成一个逻辑单元,提供数据冗余、性能提升或两者兼备的解决方案。根据数据分布和冗余策略的不同,RAID分为多个级别。

2.2 常用RAID级别详解

RAID 0(条带化)

• 特点:数据分条存储,无冗余

• 优势:读写性能翻倍,存储空间利用率100%

• 劣势:任何一块磁盘故障导致全部数据丢失

• 适用场景:临时数据存储,性能要求极高的场景

RAID 1(镜像)

• 特点:数据完全镜像,50%存储利用率

• 优势:高可靠性,单磁盘故障不影响服务

• 劣势:存储成本高,写入性能略有下降

• 适用场景:关键系统盘,重要数据存储

RAID 5(分布式奇偶校验)

• 特点:数据条带化 + 分布式奇偶校验

• 优势:平衡性能和冗余,存储利用率(n-1)/n

• 劣势:写入性能较差,重建时间长

• 适用场景:企业级数据存储,读多写少的应用

RAID 6(双奇偶校验)

• 特点:两个独立的奇偶校验信息

• 优势:可容忍两块磁盘同时故障

• 劣势:写入性能更差,存储利用率(n-2)/n

• 适用场景:大容量存储,对可靠性要求极高的场景

RAID 10(1+0)

• 特点:先镜像后条带化

• 优势:兼具RAID 0和RAID 1的优点

• 劣势:存储利用率仅50%,成本高

• 适用场景:数据库存储,高性能高可靠性要求

2.3 软RAID实战配置

使用mdadm创建RAID

# 创建RAID 1 mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/sdb /dev/sdc # 创建RAID 5 mdadm --create /dev/md1 --level=5 --raid-devices=3 /dev/sdd /dev/sde /dev/sdf # 创建RAID 10 mdadm --create /dev/md2 --level=10 --raid-devices=4 /dev/sdg /dev/sdh /dev/sdi /dev/sdj

RAID状态监控

# 查看RAID状态 cat /proc/mdstat mdadm --detail /dev/md0 # 监控RAID事件 mdadm --monitor --scan --daemonise

RAID维护操作

# 标记故障磁盘 mdadm --manage /dev/md0 --fail /dev/sdb # 移除故障磁盘 mdadm --manage /dev/md0 --remove /dev/sdb # 添加新磁盘 mdadm --manage /dev/md0 --add /dev/sdx # 停止RAID mdadm --stop /dev/md0

2.4 RAID最佳实践

性能优化

# 设置读取预读大小 echo 8192 > /sys/block/md0/md/stripe_cache_size # 调整块设备队列深度 echo 32 > /sys/block/md0/queue/nr_requests

监控告警

# 配置邮件告警 echo "MAILADDR admin@company.com" >> /etc/mdadm/mdadm.conf echo "MAILFROM raid-monitor@company.com" >> /etc/mdadm/mdadm.conf

三、NFS(网络文件系统)

3.1 NFS架构原理

NFS是基于RPC(远程过程调用)的分布式文件系统,允许网络中的计算机共享文件和目录。NFS采用客户端-服务器架构,通过网络透明地访问远程文件系统。

3.2 NFS版本对比

NFSv3特性

• 支持大文件(64位文件偏移量)

• 异步写入提升性能

• 支持TCP和UDP协议

• 弱一致性模型

NFSv4特性

• 集成安全机制(Kerberos支持)

• 状态化协议,提供文件锁定

• 支持委托(delegation)机制

• 复合操作减少网络延迟

• 国际化支持(UTF-8)

3.3 NFS服务器配置

安装NFS服务

# RHEL/CentOS yum install -y nfs-utils rpcbind # Ubuntu/Debian apt-get install -y nfs-kernel-server

配置NFS导出

# 编辑/etc/exports文件 /data/shared 192.168.1.0/24(rw,sync,no_subtree_check,no_root_squash) /data/public *(ro,sync,no_subtree_check,all_squash,anonuid=65534,anongid=65534) /data/backup 192.168.1.10(rw,sync,no_subtree_check,root_squash)

导出选项详解

• rw/ro:读写/只读权限

• sync/async:同步/异步写入

• no_subtree_check:禁用子目录检查

• root_squash/no_root_squash:root用户权限映射

• all_squash:所有用户映射为匿名用户

• anonuid/anongid:匿名用户ID

启动NFS服务

# 启动服务 systemctl enable --now rpcbind nfs-server # 重新加载导出配置 exportfs -ra # 查看当前导出 exportfs -v showmount -e localhost

3.4 NFS客户端配置

挂载NFS共享

# 临时挂载 mount -t nfs -o vers=4,rsize=32768,wsize=32768,hard,intr 192.168.1.100:/data/shared /mnt/nfs # 永久挂载(/etc/fstab) 192.168.1.100:/data/shared /mnt/nfs nfs vers=4,rsize=32768,wsize=32768,hard,intr 0 0

挂载选项优化

• vers=4:指定NFS版本

• rsize/wsize:读写块大小

• hard/soft:重试策略

• intr:允许中断操作

• timeo:超时时间

• retrans:重传次数

3.5 NFS性能优化

网络优化

# 调整网络缓冲区大小 echo 'net.core.rmem_default = 262144' >> /etc/sysctl.conf echo 'net.core.rmem_max = 16777216' >> /etc/sysctl.conf echo 'net.core.wmem_default = 262144' >> /etc/sysctl.conf echo 'net.core.wmem_max = 16777216' >> /etc/sysctl.conf sysctl -p

NFS服务器优化

# 增加NFS守护进程数量 echo 'RPCNFSDCOUNT=32' >> /etc/sysconfig/nfs # 配置NFS缓存 echo 'vm.dirty_ratio = 5' >> /etc/sysctl.conf echo 'vm.dirty_background_ratio = 2' >> /etc/sysctl.conf

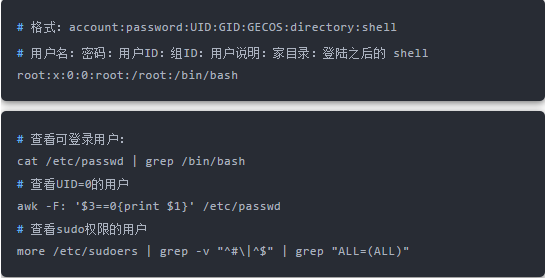

3.6 NFS安全配置

使用Kerberos认证

# 服务器端配置 /data/secure 192.168.1.0/24(rw,sync,sec=krb5p,no_subtree_check) # 客户端挂载 mount -t nfs -o vers=4,sec=krb5p server:/data/secure /mnt/secure

防火墙配置

# 固定NFS端口 echo 'STATD_PORT=32765' >> /etc/sysconfig/nfs echo 'LOCKD_TCPPORT=32766' >> /etc/sysconfig/nfs echo 'LOCKD_UDPPORT=32766' >> /etc/sysconfig/nfs echo 'MOUNTD_PORT=32767' >> /etc/sysconfig/nfs # 开放防火墙端口 firewall-cmd --permanent --add-service=nfs firewall-cmd --permanent --add-service=rpc-bind firewall-cmd --permanent --add-service=mountd firewall-cmd --reload

四、综合应用案例

4.1 企业级存储架构设计

在实际生产环境中,通常需要将LVM、RAID和NFS技术结合使用。以下是一个典型的企业级存储架构设计:

底层存储层(RAID)

# 创建RAID 10阵列作为高性能存储 mdadm --create /dev/md0 --level=10 --raid-devices=4 /dev/sdb /dev/sdc /dev/sdd /dev/sde # 创建RAID 6阵列作为大容量存储 mdadm --create /dev/md1 --level=6 --raid-devices=6 /dev/sdf /dev/sdg /dev/sdh /dev/sdi /dev/sdj /dev/sdk

逻辑卷管理层(LVM)

# 创建物理卷 pvcreate /dev/md0 /dev/md1 # 创建卷组 vgcreate vg_performance /dev/md0 vgcreate vg_capacity /dev/md1 # 创建逻辑卷 lvcreate -L 50G -n lv_database vg_performance lvcreate -L 20G -n lv_logs vg_performance lvcreate -L 500G -n lv_backup vg_capacity lvcreate -L 1T -n lv_archive vg_capacity

文件系统层

# 创建文件系统 mkfs.ext4 /dev/vg_performance/lv_database mkfs.ext4 /dev/vg_performance/lv_logs mkfs.xfs /dev/vg_capacity/lv_backup mkfs.xfs /dev/vg_capacity/lv_archive

NFS共享层

# 配置NFS导出 echo '/data/database 192.168.1.0/24(rw,sync,no_subtree_check,no_root_squash)' >> /etc/exports echo '/data/backup 192.168.1.0/24(rw,sync,no_subtree_check,root_squash)' >> /etc/exports echo '/data/archive 192.168.1.0/24(ro,sync,no_subtree_check,all_squash)' >> /etc/exports

4.2 自动化运维脚本

存储健康检查脚本

#!/bin/bash

# storage_health_check.sh

# 检查RAID状态

check_raid() {

echo "=== RAID Status ==="

cat /proc/mdstat

for md in $(ls /dev/md* 2>/dev/null); do

mdadm --detail $md | grep -E "(State|Failed|Spare)"

done

}

# 检查LVM状态

check_lvm() {

echo "=== LVM Status ==="

vgs --noheadings -o vg_name,vg_size,vg_free

lvs --noheadings -o lv_name,lv_size,lv_attr

}

# 检查NFS状态

check_nfs() {

echo "=== NFS Status ==="

exportfs -v

showmount -e localhost

}

# 磁盘空间检查

check_disk_space() {

echo "=== Disk Space ==="

df -h | grep -E "^/dev/(md|mapper)"

}

# 执行检查

check_raid

check_lvm

check_nfs

check_disk_space4.3 监控告警集成

Zabbix监控模板

# 创建自定义监控脚本

cat > /etc/zabbix/scripts/raid_status.sh << 'EOF'

#!/bin/bash

RAID_DEVICE=$1

if [ -z "$RAID_DEVICE" ]; then

echo "Usage: $0 <raid_device>"

exit 1

fi

STATUS=$(mdadm --detail $RAID_DEVICE | grep "State :" | awk '{print $3}')

if [ "$STATUS" = "clean" ]; then

echo 0

else

echo 1

fi

EOF

chmod +x /etc/zabbix/scripts/raid_status.sh五、故障处理与恢复

5.1 RAID故障处理

磁盘故障恢复

# 检查故障磁盘 mdadm --detail /dev/md0 # 热替换故障磁盘 mdadm --manage /dev/md0 --remove /dev/sdb mdadm --manage /dev/md0 --add /dev/sdx # 监控重建进程 watch -n 5 'cat /proc/mdstat'

5.2 LVM故障处理

逻辑卷修复

# 检查LVM元数据 vgcfgbackup vg_data vgcfgrestore -f /etc/lvm/backup/vg_data vg_data # 激活逻辑卷 vgchange -ay vg_data

5.3 NFS故障处理

NFS服务恢复

# 检查NFS服务状态 systemctl status nfs-server rpcbind # 清理NFS锁定 rm -rf /var/lib/nfs/statd/sm/* systemctl restart nfs-server

六、最佳实践总结

6.1 设计原则

可靠性优先:关键数据必须有冗余保护,建议使用RAID 1或RAID 10

性能考虑:根据应用特性选择合适的RAID级别和文件系统

扩展性规划:使用LVM提供灵活的容量管理

监控告警:建立完善的监控体系,及时发现问题

6.2 运维规范

定期备份:制定备份策略,定期测试恢复流程

容量规划:监控存储增长趋势,提前进行容量扩展

性能调优:根据业务负载特性调整系统参数

文档记录:详细记录配置变更和故障处理过程

6.3 安全建议

访问控制:严格控制NFS访问权限,使用网络分段

数据加密:敏感数据传输使用加密协议

审计日志:启用文件系统审计,记录关键操作

定期检查:定期检查存储系统健康状态

结语

高级文件系统管理技术是现代运维工程师的核心技能之一。通过合理运用LVM、RAID和NFS技术,可以构建高可用、高性能、易管理的企业级存储系统。在实际应用中,需要根据具体业务需求和技术环境,制定合适的存储架构方案。

随着云计算和容器技术的发展,传统的存储管理方式也在不断演进。运维工程师需要持续学习新技术,将传统存储管理经验与现代基础设施相结合,为企业提供更加可靠和高效的存储解决方案。

持续的监控、定期的维护和及时的故障处理是保障存储系统稳定运行的关键。建议建立完善的运维流程和应急预案,确保在各种情况下都能快速响应和处理问题,最大限度地保障业务连续性。

上篇:

2025年性价比最高的AI服务器拆解:768GB显存暴打训练慢的痛点

下篇:

网络故障秒排指南:10 个实战命令从入门到精通

1 电商必懂的数据公式 2 AI新玩法,制作历史大事件视频,涨粉20w,获赞220w 3 一句话生成100集AI漫剧!手把手干货教程! 4 做跨境电商步骤 5 智能目标检测:用 Rust + dora-rs + yolo 构建“机器之眼” 6 根据工作岗位要求, 写一份现场面试者工作自我介绍简述, 要求800字 7 网络故障秒排指南:10 个实战命令从入门到精通 8 男人若想发大财,就莫要去打工,我推荐做这二十件事。 9 K8S常用命令手册 10 运维必备:掌握这3个存储技术 11 win11 连接共享打印机报错:0x00000040 或者 .709或者 .11... 12 跨境电商店铺源头 选品很重要哦