2024/01 作者:ihunter 0 次 0

https://github.com/QwenLM/Qwen

https://modelscope.cn/models/qwen/Qwen-14B/summary

通义千问-14B(Qwen-14B)是阿里云研发的通义千问大模型系列的140亿参数规模的模型。Qwen-14B是基于Transformer的大语言模型, 在超大规模的预训练数据上进行训练得到。预训练数据类型多样,覆盖广泛,包括大量网络文本、专业书籍、代码等。同时,在Qwen-14B的基础上,我们使用对齐机制打造了基于大语言模型的AI助手Qwen-14B-Chat。本仓库为Qwen-14B的仓库。

通义千问-14B(Qwen-14B)主要有以下特点:

大规模高质量训练语料:使用超过3万亿tokens的数据进行预训练,包含高质量中、英、多语言、代码、数学等数据,涵盖通用及专业领域的训练语料。通过大量对比实验对预训练语料分布进行了优化。

强大的性能:Qwen-14B在多个中英文下游评测任务上(涵盖常识推理、代码、数学、翻译等),效果显著超越现有的相近规模开源模型,甚至在部分指标上相比更大尺寸模型也有较强竞争力。具体评测结果请详见下文。

覆盖更全面的词表:相比目前以中英词表为主的开源模型,Qwen-14B使用了约15万大小的词表。该词表对多语言更加友好,方便用户在不扩展词表的情况下对部分语种进行能力增强和扩展。

---要求(Requirements)

python 3.8及以上版本

pytorch 1.12及以上版本,推荐2.0及以上版本

建议使用CUDA 11.4及以上(GPU用户、flash-attention用户等需考虑此选项)

python 3.8 and above

pytorch 1.12 and above, 2.0 and above are recommended

CUDA 11.4 and above are recommended (this is for GPU users, flash-attention users, etc.)

---依赖项

pip install transformers4.32.0 accelerate tiktoken einops scipy transformers_stream_generator0.0.4 peft deepspeed

-推荐安装flash-attention库,以实现更高的效率和更低的显存占用

git clone -b v1.0.8 https://github.com/Dao-AILab/flash-attention

cd flash-attention && pip install .

# 下方安装可选,安装可能比较缓慢。

# Below are optional. Installing them might be slow.

# pip install csrc/layer_norm

# pip install csrc/rotary

---中文介绍

https://github.com/QwenLM/Qwen/blob/main/README_CN.md

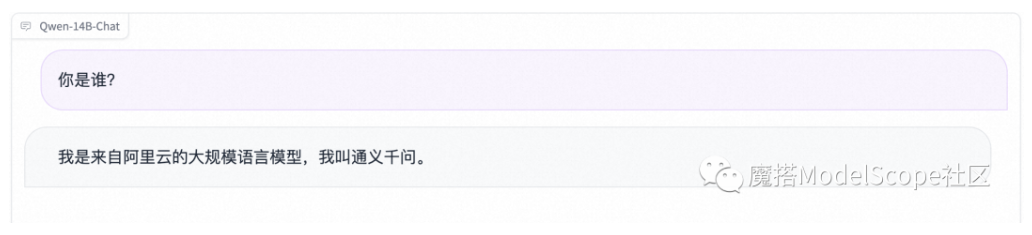

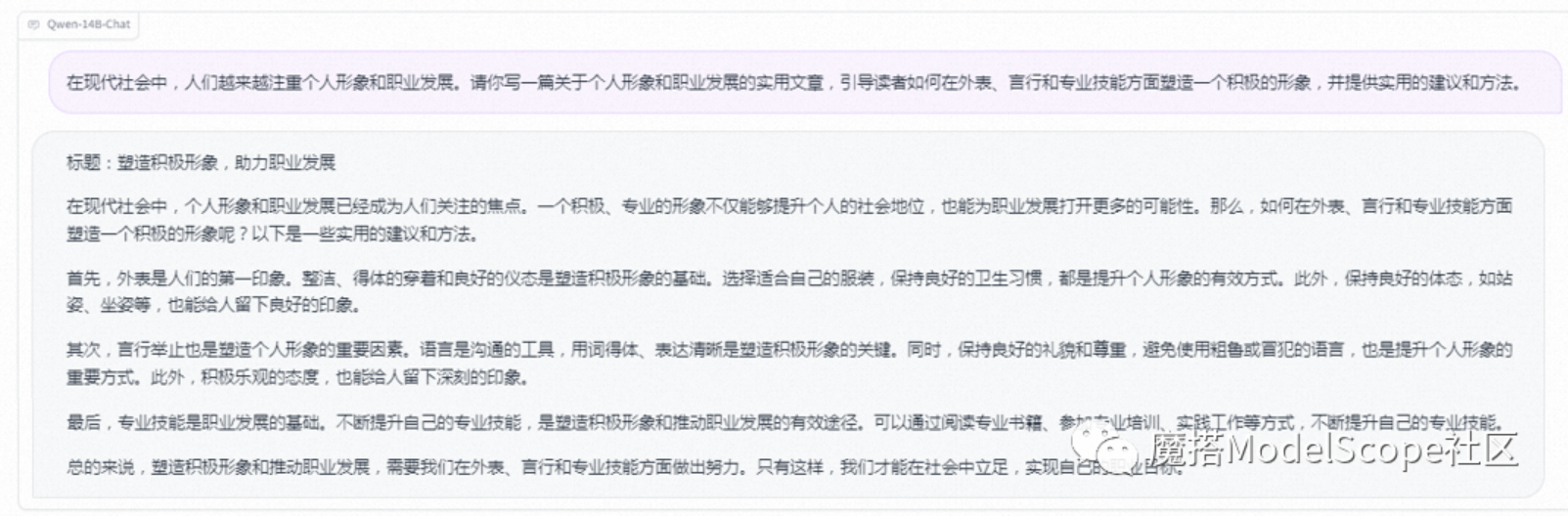

---效果展示

国际惯例自我认知

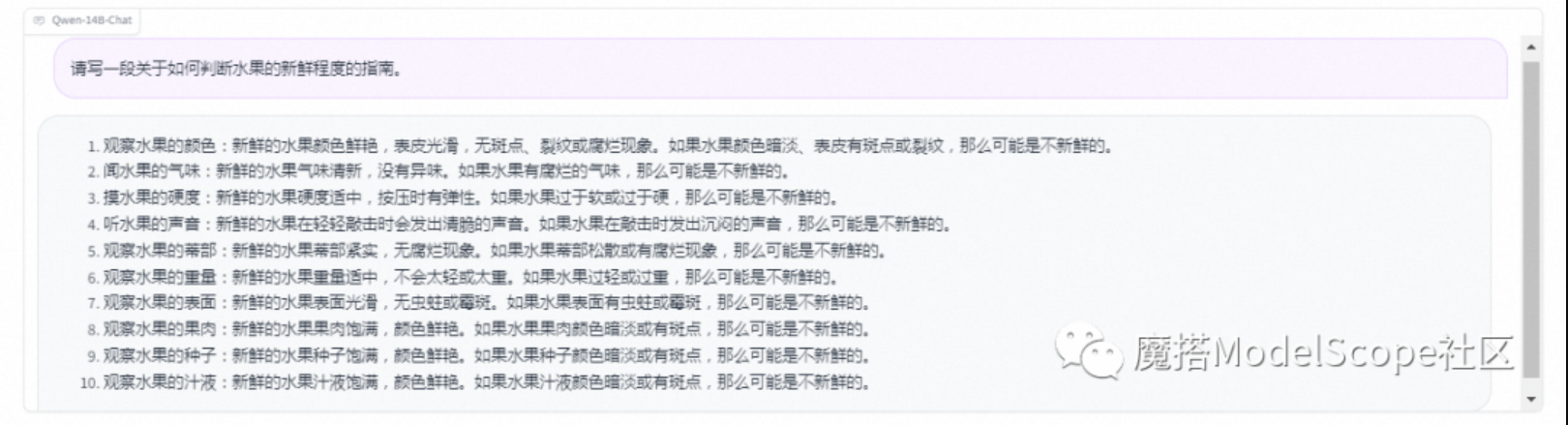

写作创作

知识常识

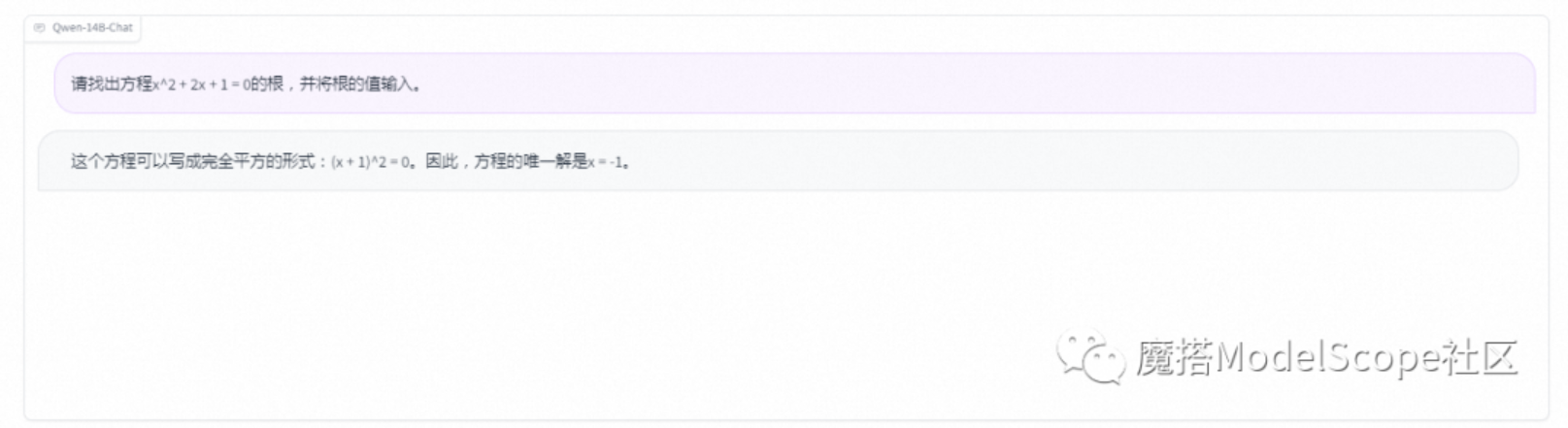

数学

代码

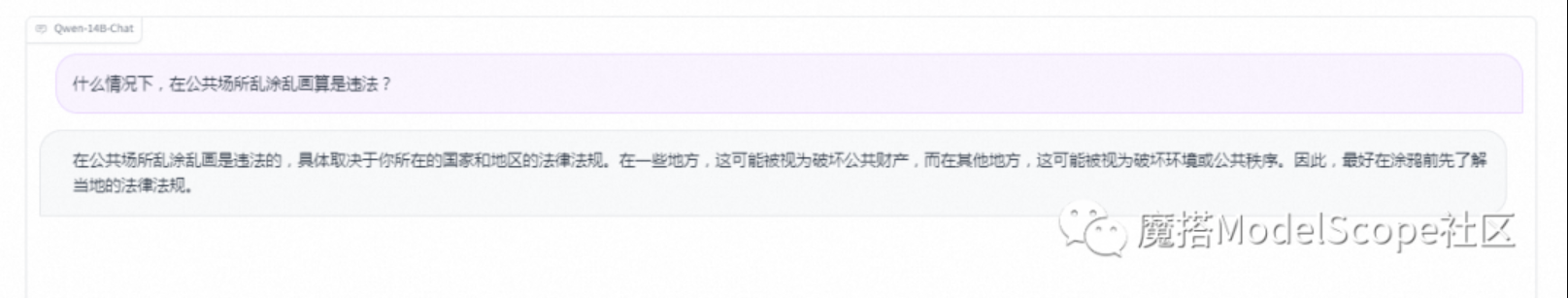

安全

上篇:

seatunnel - 海量数据(离线&实时)同步和转化的数据集成平台 -Spark && Flink

下篇:

LlamGPT - 基于Llama2的聊天机器人